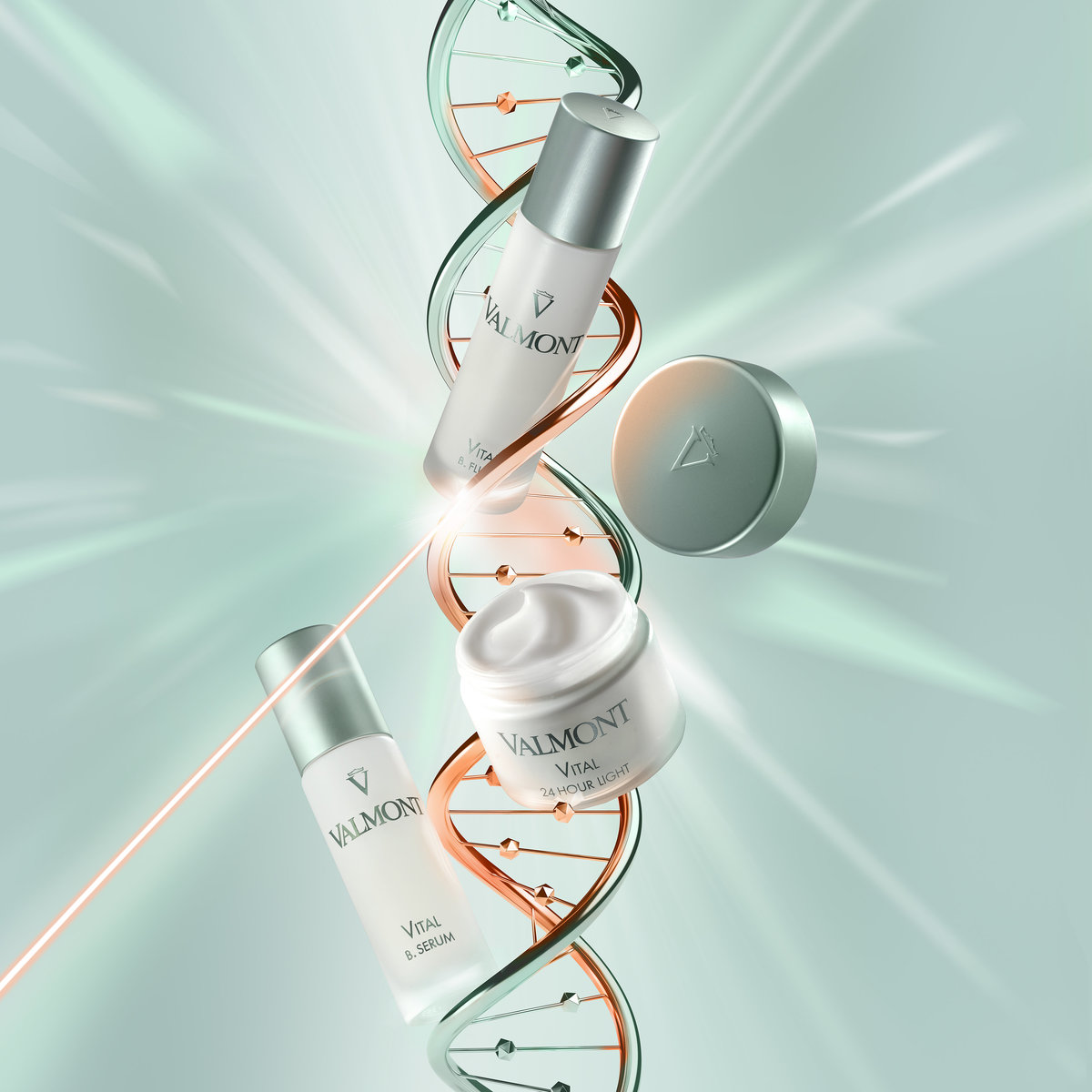

VALMONT,時光魔法師 歡慶品牌40周年

全新甦活新肌系列 重啟匿齡甦活力

新世代奢華護膚 解鎖十大肌膚老化關鍵

1985年,Valmont 被譽為「時光魔法師」的瑞士頂級品牌誕生。至 2025年,經過40年,Valmont 專注於卓越獨特的DNA以及各種獨家護膚科研,結合瑞士純淨大自然資源,為消費者帶來令人驚艷護膚體驗。Valmont 期望每一張面孔擁有

「健康透亮」的肌膚,為此持續不斷研究卓越獨家護膚科技,發展出不同功效以及質地的護膚系列。

歡慶品牌 40周年之際, Valmont 執行長Sophie VannGuillon 與護膚研究團隊大膽地將Valmont 經典「Energy活力生機」系列升級。她表示:「一直以來,創新高端科技, 引領Valmont 研發獨家DNA成分,提供肌膚活力,散發健康光採。2025年,Valmont 成功地研發全新具卓越功效的DNA成分,得以再創經典系列,施展時光魔法師的神奇匿齡魔法。」

十大老化徵兆

反映肌膚活力生機逐漸衰退

當身體發出疲憊訊號時,易怒、嗜睡不醒、肌肉痠痛、無精打採等徵兆就會出現,代表身體能量逐漸流失。

然而,肌膚開始失去活力生機時,卻較少人意識到。Valmont 提出十大老化徵兆,反映肌膚活力逐漸失去,導致肌膚開始老化。

肌膚老化徵兆:

• 肌膚缺氧黯淡無光

• 膚色不均,斑點色素沉澱

• 肌膚乾燥缺水

• 毛孔粗大

• 肌膚粗糙,彈性逐漸消失

• 感受到肌膚變薄

• 肌膚無緊緻度,鬆弛下垂

• 肌膚對環境的耐受度下降,易泛紅敏感。

若肌膚開始出現三個或更多上述徵兆,代表肌膚失去原本健康的活力生機,逐漸老化。Valmont 了解活力具有能量的肌膚是大家所追求的,而肌膚外表的活力來自於肌膚內的活力。2025年,Valmont 歡慶40周年之際,重塑護膚新科技,引領業界創新,透過40年來的護膚科研經驗,誕生革命性全新的DNA活性成分,推出「VITALITY 甦活新肌」系列,聚焦全新獨家DNA成分「矽醇甦活複合DNA」,結合HP 高聚合分子DNA的再生能量與矽醇的重組特色,協同高濃度的「褐藻礦物複方」,煥活肌膚,完成再生、重組、煥活三大賦活力,賦予肌膚「細緻」、「活化」、「柔嫩」、「水潤」、「透亮」、「無瑕」、「緊緻」、「滋養」、「無痕」、「豐盈」,逆轉上述的十大老化跡象。

全新革命性獨家DNA成分

矽醇甦活複合DNA 重啟匿齡賦活力

Valmont DNA 自1985年品牌創立以來,一直是Valmont 護膚品的獨家關鍵成分。追溯至1980年代活護膚研究,Valmont 的獨特DNA成分透過專利的科研技術,提取野生雄性鮭魚的DNA,因無與倫比的保濕功效受到護膚品牌喜愛。過去40年,Valmont 持續精進研究其專利DNA,研發出不同DNA得以卓越地應用到Valmont 的保養品中。2025年,Valmont 突破再精進,研發推出全新獨家專利活性DNA成分 – 「矽醇甦活複合DNA」。

護膚抗老研究中,最常提到試圖延長肌膚壽命,但Valmont 選擇了一種不同的方式。因此,Valmont 於40周年之際,開發並發表「矽醇甦活複合DNA」成分,結合「HP 高聚合分子DNA」的再生能量與「矽醇」的重組特色,並協同高濃度的礦物質環境,達到1+1 = 3 的卓越非凡功效。

1 + 1 = 3

「矽」在生物學中,有三種不同的型態,結晶矽、非晶質以及矽醇,「矽醇」為Valmont 此次使用的矽型態,可是礦物質被肌膚吸收,穿越肌膚屏障重組結構。它高於碳元素146倍,人自出生至40歲時,人體內的矽含量會減少58%。Valmont 將DNA的再生能力與矽醇的重組能力結合,開發出「矽醇甦活複合DNA」,產生了全新肌膚活化作用,包含ATP提供能量、修護更新肌膚自噬以及深層保濕。而「矽醇甦活複合DNA」的卓越功效亦透過創新技術 – 「甦活蛋白解碼技術(PROTEOMIC

ANALYSIS)」驗證,研究顯示可精準作用於3,557種蛋白,重啟肌膚再生活力,給予肌膚「細緻」、「活化」、「柔嫩」、「水潤」、「透亮」、「無瑕」、「緊緻」、「滋養」、「無痕」、「豐盈」,力抗十大老化跡象。

甦活新肌系列不僅富含「矽醇甦活複合DNA」,更添加「甦活新肌雞尾酒植物萃取配方」,互相結合,得以看到卓越非凡的護膚功效:

• 微脂囊 RNA:深入擴散與滲透肌底,修護肌膚。

• 褐藻礦物複合配方: 提供豐富的礦物質

透過這些成分的卓越功效,「甦活新肌」系列使肌膚開始擁有健康的肌膚生態圈,重啟匿齡賦活力,散發健康光採。

全新甦活新肌系列 重啟匿齡甦活力

全新的「甦活新肌」系列,包含「甦活新肌再生精華」、「甦活新肌再生眼脣霜」、「甦活新肌再生水凝乳」,「甦活新肌再生24小時霜」以及「甦活新肌再生1號霜」。一款臉部精華、一款針對眼周護理的眼霜以及三款不同質地的乳霜,提供不限年齡的無性別抗老護膚保養品,全方位逆轉肌膚疲勞缺乏能量問題,使肌膚「細緻」、「活化」、「柔嫩」、「水潤」、「透亮」、「無瑕」、「緊緻」、「滋養」、「無痕」、「豐盈」,重啟甦活再生力。

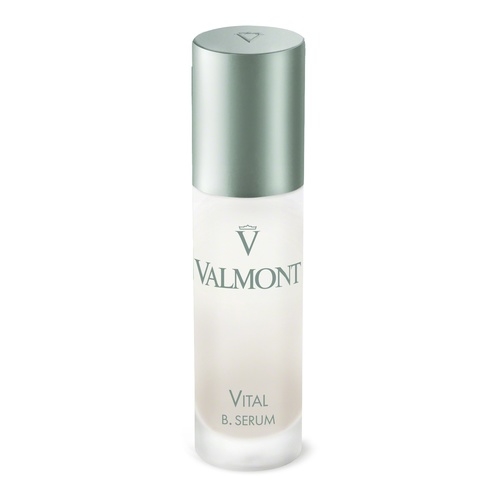

甦活新肌再生精華 ( VITAL B. SERUM)

30ML / NT$8,700元

靈感來自於「肌密再生活膚液」,乳白色的輕盈乳狀質地,富含「矽醇甦活複合DNA」與「甦活新肌雞尾酒植物萃取配方」外,更添加「錦葵萃取」,為所有膚質皆適用的全能瞬效精華,加強肌膚舒緩,為肌膚保養奠定基礎,日間啟動肌膚活力,夜晚修護滋養,對抗肌膚疲憊跡象,帶給肌膚水潤,嫩亮, 平滑,緊緻。

使用方式:日/晚間使用,清潔臉部,化妝水步驟後取適量,塗抹於臉部和頸部後按摩直至精華被肌膚完全吸收。

Valmont 法兒曼

甦活新肌再生精華

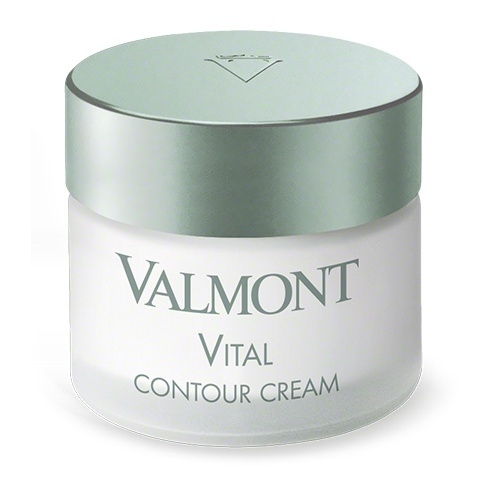

甦活新肌再生眼脣霜 ( VITAL CONTOUR CREAM)

15ML / NT$6,800元

靈感來自於「肌密再生眼脣霜」與「肌密防禦活氧眼霜」,質地豐潤細膩,唯一款全面呵護眼周肌膚的必備盟友。其配方多添加「乳酸薄荷酯」,舒適煥活眼周肌膚,緊緻,明亮眼周肌膚。

使用方式:日/晚間使用,取適量利用無名指輕點眼霜至眼周,沿著眼周至太陽穴輕柔按摩至吸收。

Valmont 法兒曼

甦活新肌再生眼脣霜

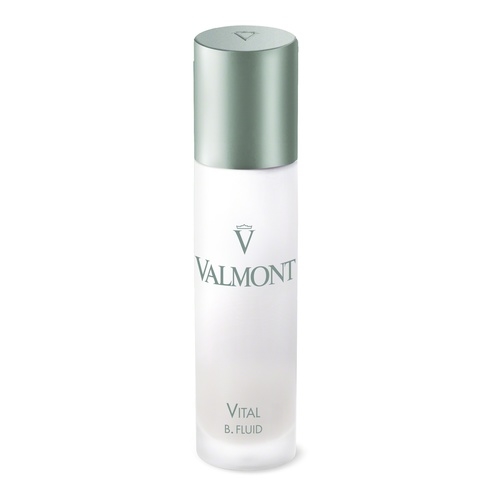

甦活新肌再生水凝乳 ( VITAL B. FLUID)

50ML / NT$9,500元

靈感來自於「極緻保濕精華乳」,質地輕盈水凝乳狀,成分多添加「薄荷純露」,舒緩刺激,對抗疲憊、壓力、老化的肌膚,幫助肌膚恢復輕盈、水透、柔滑、細緻,為日常護理必備。適合混和性、油性以及也推薦男性使用。

使用方式:日/晚間使用,清潔臉部,精華液步驟後取適量,塗抹於臉部和頸部後按摩直至精華被肌膚完全吸收。

Valmont 法兒曼

甦活新肌再生水凝乳

甦活新肌再生24小時霜 (VITAL 24 HOUR LIGHT)

50ML / NT$9,500元

靈感來自於「肌密24小時再生潤膚霜」,質地為輕盈乳霜狀,塗抹時瞬間滲透,「千葉玫瑰精萃」提供天然保濕效果。日晚間使用,修護滋養,恢復活力抵抗疲憊與壓力,肌膚恢復滋潤、透亮、緊緻,柔滑的狀態。

使用方式:日/晚間使用,清潔臉部,精華液步驟後取適量,塗抹於臉部和頸部後按摩直至精華被肌膚完全吸收。

Valmont 法兒曼

甦活新肌再生24小時霜

甦活新肌再生1號霜 ( VITAL REGENERA I RICH)

50ML / NT$9,500元

靈感來自於「肌密再生1號霜」與「肌密防禦活氧霜」,質地為滋潤霜狀,除核心成分外,多添加「乳木果油」,強化卓越的保濕與修護力,「甦活新肌再生1號霜」具滋養、修護與活化肌膚功效,適合偏乾燥肌膚,豐潤滋養肌膚,使肌膚柔滑細緻。

使用方式:日/晚間使用,清潔臉部,精華液步驟後取適量,塗抹於臉部和頸部後按摩直至精華被肌膚完全吸收。

「甦活新肌系列」為Valmont 保養流程中,最不可或缺的保養品項,適時帶給肌膚能量,使肌膚光採透亮,力抗十大老化跡象。全新「甦活新肌系列」可搭配Valmont 其他系列產品一起使用,使護膚效果加乘,推薦搭配Valmont風靡40年的經典明星產品「肌密更新面膜」,以每週厚敷30分鐘,加強修護抗老,瞬間揮別疲憊,展現閃耀光採。此外,更可依照個人膚況,從不同系列找出互相搭配產品使用。

Valmont 法兒曼

甦活新肌再生1號霜

金屬綠、療癒和諧、永續精神

呈現品牌核心價值

為慶祝品牌40週年以及全新甦活新肌系列的上市,Valmont 將經典產品重新詮釋,以全新的永續設計展現品牌精神。瓶身採用可回收的霧面玻璃材質,瓶蓋則以金屬綠致敬品牌起源——Valmont Clinic 療養莊園的手術袍綠,搭配柔和的霧面白瓶身,完美呼應大自然的純淨與和諧之美。

此外,為實踐 Valmont 的永續承諾,產品說明書以專屬 QR Code 替代紙本,減少紙張使用,進一步減輕對環境的負擔。Valmont 希望透過這些行動,為環境永續貢獻一份心力,守護地球的生態之美,並向世界傳遞品牌對自然與未來的承諾。

VALMONT,Magicien du Temps時光魔法師

40年來的非凡耀眼時刻

擁有「時光魔法師」美譽之稱的瑞士頂級護膚品牌Valmont,以創新的DNA護膚科研、瑞士天然冰山泉水以及高山有機植物萃取為成分核心,閃耀護膚領域。2025年,Valmont 將歡慶品牌40周年。

40年來,Valmont的精神核心融合了護膚科學、自然資源與藝術,目標帶給眾人卓越非凡的護膚美容體驗。Valmont 完美且令人驚豔的護膚美容體驗,可追溯至1905年,亨利-奧古斯特·維德梅博士 (Dr. Henry-Auguste Widmer) 於瑞士蒙特勒日內瓦湖畔創立了醫療莊園 Valmont Clinic,以專業且創新護膚美容科學脫穎而出,許多當時的貴族政商名流於此尋找抗老逆齡之法及恢復身心。Valmont 護膚保養品牌 ,汲取靈感,醫療莊園 Valmont Clinic 與美容博士Nadia Avalle共同推出極具功效護膚品與建立品牌。

淵源初始,護膚科學使Valmont 極具創新且與眾不同,以「仿生活性分子」為原理,旨在卓越的生物相仿性,使肌膚與活性成分完美契合,使Valmont 每一樣護膚產品提升功效且效果顯著。1990年開始,Didier Guillon,一位具有獨創精神的藝術家,掌舵Valmont,於2000年起,Sophie Vann Guillon,一位充滿熱情活力的願景家,一同加入引領護膚美學與藝術的發展。她,擁有天生於護膚保養專業知識敏感直覺﹔他,擁有大膽且驚豔眾人的藝術創造力,兩位夥伴,互相互補,不斷重新定義「美」。

這裡沒有繆斯,明星就是產品!

產品即為Valmont的謬思女神!

如何定義Valmont 致臻完美的肌膚 ? Valmont 認為肌膚光滑具有彈性,閃耀健康的光採,即為Valmont 最完美的肌膚。Valmont護膚核心融合了卓越獨家的創新護膚科技與瑞士純淨的大自然資源,於阿爾卑斯山海拔超過2,000公尺的瓦萊州,有座高山有機花園,如同露天的實驗室般,栽種了有著獨特的麝香玫瑰、沙棘與紫錐花等天然植物,Valmont 實驗室以特殊方式萃取其成分,結合純淨冰山泉水,富含對肌膚有益的礦物質,讓Valmont 護膚產品有著卓越非凡的功效。

Valmont於40年的旅程中,不侷限自己僅作為護膚品品牌,不斷於獨家DNA成分與其他配方上精進,並追求五感奢華體驗,使顧客於品牌體驗上感受到不同的魔力。Valmont SPA 於2003年初開幕,延伸至全球頗具盛名五星級飯店,使各地旅人真正體驗獨特蝴蝶手法與芳療服務。護膚品、芳療手法與獨創音樂的結合成為最具療癒性的自然樂聲,邀請每一位顧客於都市綠洲中放鬆療癒自我。。

藝術在東西方的歷史文化中始終有著不同的地位,而藝術亦賦予了Valmont不同與其他品牌美的能量,貫徹「生活藝術」的哲學。40年來,「藝術與美的相遇」 (When Art Meets Beauty) 不斷被重新詮釋,強化藝術與美的連結。發展至今日,Valmont創造了無與倫比的體驗空間,如2016年開立了第一家La Maison Valmont 精品旗艦店以及於2020年開幕首座Résidences Valmont,將創辦人獨特的美學眼光加入空間中,將藝術品味不斷傳遞到每個顧客身上。

「La Maison Valmont」 精品旗艦店,為最好的護膚藝術美學的呈現。空間超越專業護膚,將當代藝術與藝術總監獨到的藝術眼光結合Valmont 護膚品交織,使每位顧客進入空間時,遠離城市喧囂,產品、護膚與藝術互相融合,享受一段奢華的五感饗宴。

自「La Maison Valmont」開始,Valmont一直致力於藝術的推廣,藝術、護膚,生活態度為三大核心,期望每一位Valmont顧客感受到這份用心。自2020年開始,Valmont 藝術基金會開幕了「Résidences Valmont」,推廣當地獨特且具文化氛圍的永恆優雅空間,提供獨一無二的旅遊行程,打造沉浸式的生活藝術。目前共有四處「Résidences Valmont」,分別位於義大利威尼斯、西班牙巴塞隆納、瑞士爾比耶(Verbier)以及希臘伊茲拉島(Hydra)。

Valmont 在永續皆展現強大的行動意志。自成分配方到供應鏈廠商抑或是自改進瓶器包裝到環境保育,Valmont皆擁有具體行動與成果,此外,位於威尼斯的Valmont 藝術基金會更通過舉辦不同的當代藝術展覽延續傳遞藝術美學,透過各種藝術形式與人對話,傳遞情感,使藝術觸手可及,不再遙遠。

Valmont於40周年之際展望未來,將拓展美的推動美的邊界,並致敬不同文化,歷史與美的傳承。Valmont 邀請每位對「美」有所堅持的人們探索科學、文化、藝術的旅程,於此,欣賞與體驗這些與美相關的連結。2025,Valmont品牌創立40周年之際,將展開全新篇章,專業護膚科研與對美的熱情將滋養肌膚和療癒心靈,生活中每一刻栩栩如生的藝術皆值得慶祝 !

標題:【Valmont 法兒曼】歡慶 VALMONT 40 周年 甦活新肌系列新品上市 新聞稿 /

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。