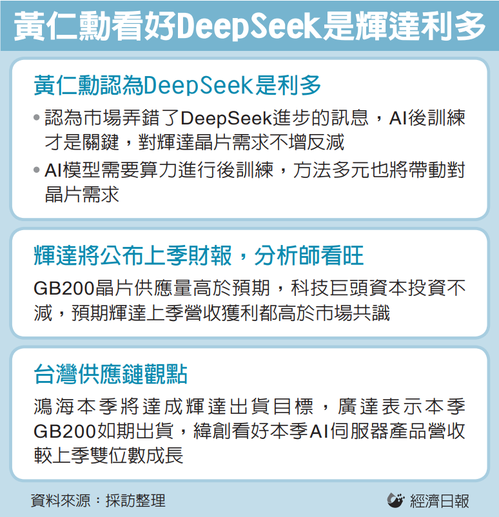

美國人工智慧()晶片龍頭(NVIDIA)執行長近期回應中國大陸DeepSeek引發輝達股價賣壓,表示投資人弄錯了DeepSeek進步的訊息,正確的訊息應該是AI的後訓練(post-training)階段才是關鍵,對輝達晶片的需求不減反增。

DeepSeek在1月發表「R1」大型語言模型(LLM),以較低的成本獲得高效能,引發美國科技巨擘的AI投資前景憂慮,拖累輝達股價在1月挫跌,但近期輝達股價幾乎已收復失土。

黃仁勳20日在合作夥伴DDN預錄的訪談影片表示,輝達股價對DeepSeek的劇烈反應,源於投資人對DeepSeek進步的解讀錯誤。AI產業仍需要運算能力進行AI模型的後訓練,後期訓練的方法多元,對輝達晶片所供應運算能力的需求也將成長。後期訓練讓AI模型能在完成訓練後,做出結論或進行預測。

黃仁勳說,「從投資人的角度來看,過去都有一種心智模型,認為世界是先預訓練(pre-training),接著再(進入)推論(階段),(投資人認知的)推論是:你問了AI一個問題,就能立刻獲得答案」,他認為,這個心智圖是不對的。

他說,預訓練仍然很重要,但後期訓練反而是最重要的智慧環節,「是(AI)學會解決問題的環節」,後期訓練方法「如火如荼」進展,AI模型持續以新的推理方法進步。他稱讚DeepSeek的創新提振AI產業的活力,「實在令人無比興奮。R1開源在全球激起的活力令人驚嘆」。

輝達26日將舉行財報說明會,黃仁勳勢必面對DeepSeek的問題,這番談話可能也是他的回應。近期的美股財報季,DeepSeek已成為熱議話題,超微(AMD)執行長蘇姿豐也被問到類似問題,她表示DeepSeek正在帶動「有利AI採用」的創新。

黃仁勳最近幾個月不斷駁斥模型擴展陷入麻煩的憂慮,在DeepSeek聲名大噪之前,1月就有報導指出OpenAI的模型進步正在放慢,輝達成長可能放緩。黃仁勳去年11月強調,模型擴展「活得很好」,只是從訓練轉向推論。

標題:黃仁勳談DeepSeek 有利輝達…對晶片需求將不減反增

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。