記者潘慧中/綜合報導

知名網路漫畫家織織分手賴賴兩年後,她2024年底宣布懷孕,「我即將迎接人生下一個篇章」,雖然沒有透露伴侶身分,但粉絲無不送上祝福。然而,她近日在社群網站坦言自從有了寶寶,舊疾便復發到「生活沒辦法自理的地步了」。

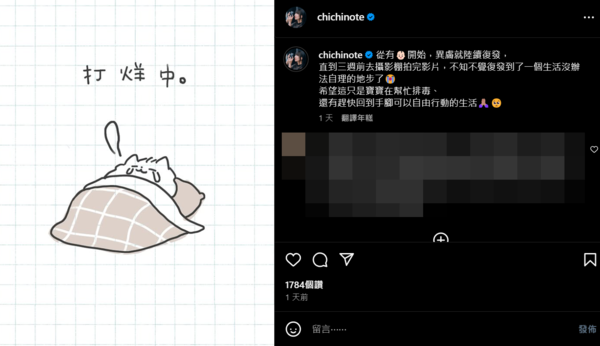

織織9日上傳了窩在被窩裡、寫著「打烊中」的手繪圖,原因是懷有身孕後,異位性皮膚炎就開始復發,直到3週前拍攝完影片,才驚覺症狀已經復發到她無法自理生活的程度。

附上一個大哭的表情符號,顯見織織無奈的心情,只能安慰自己這可能是寶寶在幫忙排毒,「希望趕快回到手腳可以自由行動的生活」,讓粉絲窺見她不容易的一面。

此外,織織10日也首度露出了明顯隆起的孕肚,身穿米白色高領上衣搭配細肩帶洋裝,四肢依然纖細。對此,她坦言因為沒什麼胃口,加上對味道變得很敏感,所以「最近孕中期反而變瘦了」。

標題:人氣漫畫家織織懷孕後「舊疾復發」!明顯孕肚照曝:生活沒辦法自理

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。